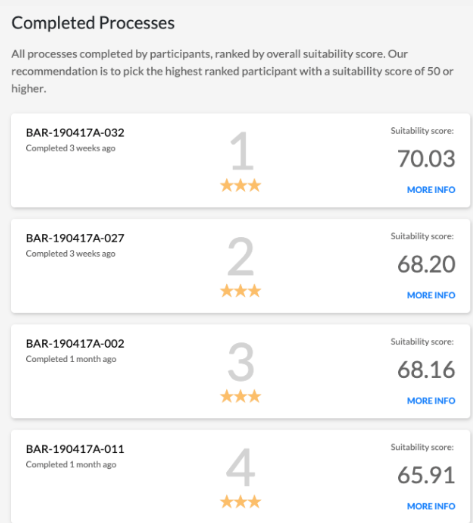

När vi utvecklade Assessment Engine inspirerades vi av den forskning som handlar om beslutsfattande. Asssessment Engine kombinerar olika resultatet till en sk Suitability Score, en lämplighetspoäng. Istället för att du som bedömare själv kombinerar en stor mängd resultat sköter algoritmer detta åt dig, du kan göra annat och samtidigt vara evidensbaserad i ditt arbete. Nu har ny forskning producerats som återigen bevisar att vi som människor inte har förmågan, som många tror, att väga ihop olika typer av information i en urvalsprocess på ett konsekvent och standardiserat sätt.

Informationen vid personbedömning för urvalsbeslut kan vägas ihop på två olika sätt. Det första tillvägagångssättet är så kallad intuitiv tolkning, vilket betyder att vägningen av informationen insamlad om kandidaten avgörs av bedömarens subjektiva tolkning. Det går till så att flera olika datainsamlingsmetoder används, tex intervju, personlighetstest, begåvningstest och referenstagning. Dessa resultat utgör sedan helhetsbedömningen som sedan blir avgörande för urvalsbeslutet.

Det andra sättet att tolka samma information är mekanisk tolkning. Denna tolkningsmetod bygger på att det finns en i förväg utvecklad evidensbaserad tolkning av informationen som anger sannolikheten att en viss individ ska prestera bättre (eller något annat man vill förutsäga) på arbetet än andra. Istället för att rekryteraren använder sin subjektiva tolkning grundas tolkningen på en väl beforskad vägning av olika informationskällor (intervju, testpoäng och CV).

Det kanske inte är konstigt att den vanliga arbetsgivaren (som ej har utbildning i personalfrågor) använder sig av den subjektiva helhetsbedömningen. Jag menar, när man i det vanliga livet träffar människor har vi en tendens att använda den intuitiva känslan för att bedöma personers egenskaper, det är enklast så och det kräver minimalt av din tankekraft, istället för att koppla på det logiska systemet så går vi direkt på känslan. Så här kan det låta när en chef (utan utbildning i bedömning) fattar sitt urvalsbeslut.

Det är en signal, en känsla som jag får att där här kommer inte att lira riktigt bra… Om det fortfarande ligger kvar och spökar…då går jag inte emot den, då litar jag på att det inte är bra, att jag inte har valt rätt i den situationen.

Men om den oinformerade chefen går på ren intuition hur är det då med de som har en längre utbildning på universitetet. Faktum är att en stor del av de som har en professionell titel, som tex rekryterare, och psykolog använder den subjektiva helhetsbedömningen, TROTS att all evidens talar för raka motsatsen. När vi frågade HR personer (via LinkedIN) för några år sedan var det hela 85% som fortfarande går på den subjektiva helhetsbedömningen. Så här kan det låta från en högt utbildad person som har personbdömning som en central arbetsuppgift

”Det intressanta ligger också ofta i det man inte förstår – i den okända variansen, relaterat till förmågan att uppfatta och märka det som avviker från det man trodde.”

Jag vill mena att båda citaten ovan beskriver samma fenomen, en överdriven tro på sin egen förmåga att se runt hörn, att känna något ingen annan känner, att vara unik bedömare, helt enkelt en övertro på sin egen förmåga.

Om vi nu ändå går på forskningen och accepterar att det mekaniska/analytiska bedömningen är överlägsen helhetsbedömningen hur mycket bättre är olika mekaniska/analytiska metoder i jämförelse med den experters helhetsbedömning.

I en alldeles färsk forskningsrapport undersöker Yu och Kuncel (2020) detta. Forskarna har undersökt hur bra en kombination av resultat av några assessment center övningar, ett personlighetstest, ett begåvningstest och intervju förutsäger arbetsprestation i två olika organisationer (tre olika grupper). I denna studie tilldelades varje kandidat sju olika poäng som antogs mäta; adjustment, administration, communication,interpersonal, judgment, leadership, and motivation.

Dessa sju poäng kombinerades på tre olika sätt:

Experternas helhetsbedömning (experten själv sätter en övergripande poäng)

Summering av alla 7 poäng (enkel viktning)

Optimal vikt genom en statistisk formel (linjär regressionsanalys)

Vid jämförelsen av de olika sätten att väga ihop informationen uppträder ett tydligt mönster. För grupp 1 är det den statistiska formeln som har högst validitet (Optimal vikt; r=.25). På andra plats kommer summeringen (Summering; r=.19) och på tredje plats helhetsbedömning (Helhetsbedömning; r=.17).

Samma mönster återfinns i grupp 2 (Optimal vikt; r=.40; Summering r=.33; Helhetsbedömning r=.16).

Och detta mönster upprepas i grupp 3; Optimal vikt=.30; Summering=.22; Helhetsbedömning =.13.

Med andra ord, i samtliga grupper hade experterna helhetsbedömning lägst validitet.

För att gräva vidare genomfördes simuleringar hur det skulle gå för de tre olika metoderna om vi skulle genomföra ett oändligt antal bedömningar. Utgångspunkten i all urvalsverksamhet är att slå slumpen, om våra bedömningar inte slår slumpen (eller har en negativt samband med kriteriet) är det helt värdelöst att göra bedömningar, då kan vi lika gärna dra lott vem som ska ha jobbet. Fördelen med slumpen är som bekant att den inte diskriminerar, samt är väldigt billig.

Så hur bra är experternas helhetsbedömning? I den första gruppen slår experterna en helt slumpmässig modell alla gånger (100%). I den andra gruppen är det 8,5% av experterna som blir slagna av slumpen och i den tredje gruppen är det faktiskt hela 22,2% av experterna som är sämre än slumpen. Det betyder att en hel del av experterna utlåtande är sämre än slumpen.

I nästa steg genomfördes en liten korrigering för att minimalt införa en systematik i bedömningen, detta skedde genom att alla individer fick samma vikt men den vikten var framtagen slumpmässigt, det var en positiv vikt som kunde variera mellan 0 till 0.5.

Om denna lilla korrigering genomförs så slår denna systematik experterna i grupp 1 i 76,83% av fallen, i grupp 2 slås alla experter (100%) och samma sak i grupp 3 (100%). Slutsatsen är att så fort en systematik genomförs så slås experterna ut, dvs de har i sina beslut lägre validitet i jämförelse med en synnerligen enkel formel, dvs att vikterna är någonstans mellan 0 och 0,5. Detta betyder att även experter som är tränade att väga ihop information av olika bedömningsmetoder är icke-konsekventa i sin bedömning.

”In conclusion, no matter how strongly a set of predictors relate to the criterion, the predictive power of a decision system is dependent on how information is combined. Consistency in weighting predictors across all judgments heavily contributes to maximizing predictive validity. The bad news is that human judges and even experts are often inconsistent” (sid 9).

En intressant iakttagelse i detta tillämpade fall är att experterna naturligtvis har möjlighet att föra in ny information i sina beslut, alltså information som inte inkluderas av de sju poängen, men ändå presterar de betydligt sämre i jämförelse med en summering av resultatet och till och med slumpmässigt framtagna vikter.

”It is possible that the expert assessors could have had more information about the candidates beyond scores on these seven assessment dimensions, such as their performanceon individual assessment activities, test profiles, and biographical information obtained from sources such as résumés and personal interaction. This could be viewed as an advantage that a human judge has over a mechanical method. Despite the possibility that the experts had this information available to them, they still performed worse than any mechanical method”. (sid 9)

Slutkommentar

Vad ska vi då ha experter till? Det är naturligtvis för att utveckla olika metoder som är valida, dvs metoder som har ett positivt samband med det beteende som ska förutsägas, tex arbetsprestation. Algoritmer, eller slumpen för den delen, kan inte utveckla nya intervjumetoder, referenstagningar, asssessment center, psykologiska test etc etc. Experter bör utveckla metoder, men absolut inte kombinera resultatet.

Vill du gratis testa Assessment Engine och Evidensbaserat urval klicka här.

Vill du kolla på hur Assessment Engine fungerar med Teamtailor klicka här

Vill du ha en demonstration av Assessment Engine maila till team@assessmentengine.se så hjälper vi dig att komma igång, helt gratis (inga licenser eller andra dolda kostnader)

Vill du läsa om hur Evidensbaserat urval fungerar och våra tests psykometriska egenskaper maila till team@assessmentengine.se så skickar vi vår tekniska manual

Referens

Yu, Martin C. and Kuncel, Nathan R. (2020). Pushing the Limits for Judgmental Consistency: Comparing Random Weighting Schemes with Expert Judgments, Personnel Assessment and Decisions: Vol. 6 : Iss. 2, Article 2. Available at: https://scholarworks.bgsu.edu/pad/vol6/iss2/2.

Lästips

Dawes, R. M., Faust, D., & Meehl, P. E. (1989). Clinical versus actuarial judgment. Science, 243, 1668- 1674.

Kuncel, N. R., Klieger, D. M., Connelly, B. S., & Ones, D. S. (2013, September 16). Mechanical versus clinical data combination in selection and admissions decisions: A meta-analysis. Journal of Applied Psychology. Advance online publication. doi: 10.1037/a0034156